Participando da MWC 2024, a Qualcomm reforçou seu compromisso na ampla adoção de Inteligência Artificial e anunciou a Qualcomm AI Hub, biblioteca que concentrará Grandes Modelos de Linguagem (LLMs) que já estejam otimizados para rodar em plataformas Snapdragon, visando facilitar a implementação desses modelos em celulares e notebooks. A gigante também aproveitou a oportunidade para demonstrar pela primeira vez modelos multimodais sendo executados localmente por um smartphone.

- GPT-5 será “melhor em tudo”, antecipa CEO da OpenAI

- Bixby pode abrir recursos do Galaxy AI com comando de voz

Os investimentos da Qualcomm em IA tem crescido nos últimos anos, com saltos significativos de desempenho da Unidade Neural de Processamento (NPU) usada na linha Snapdragon e o lançamento de diversos recursos de software para garantir o bom aproveitamento desse hardware. Nesse ponto, os esforços mais recentes da marca envolviam a Qualcomm AI Stack, um conjunto de modelos de IA otimizados para os chips da empresa.

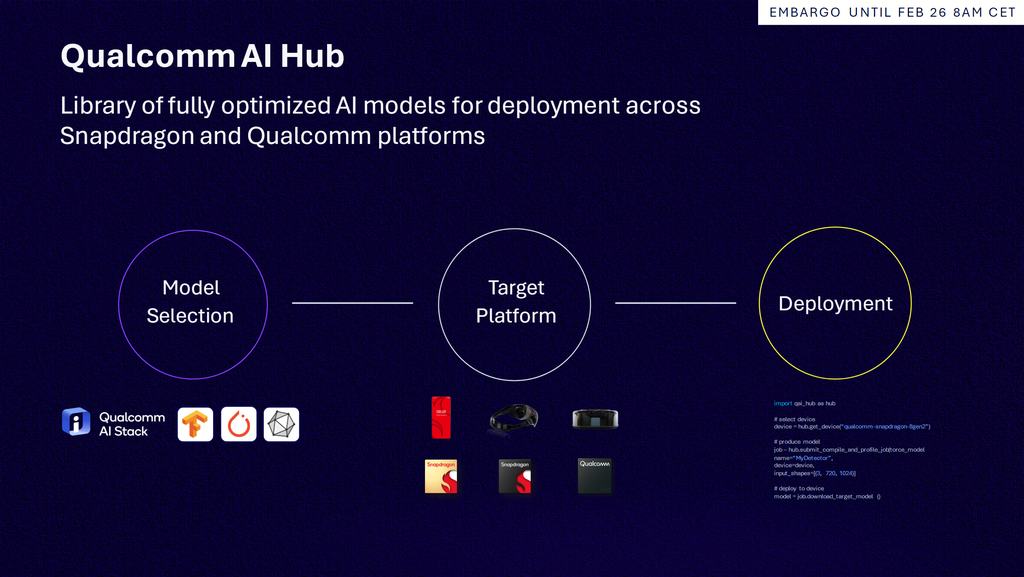

Neste ano, especialmente com o crescimento de soluções mais complexas, a gigante dá um novo passo na forma do Qualcomm AI Hub, grande biblioteca que reúne modelos de IA tradicional e de IA generativa otimizados para Snapdragon em uma central que promete facilitar sua implementação. Segundo a apresentação divulgada, o workflow seria simples, consistindo em três etapas: a seleção do modelo desejado, a seleção do dispositivo ao qual o app será destinado (smartphone, PC, etc) e a implantação no aplicativo.

–

Podcast Canaltech: de segunda a sexta-feira, você escuta as principais manchetes e comentários sobre os acontecimentos tecnológicos no Brasil e no mundo. Links aqui: https://canaltech.com.br/podcast/

–

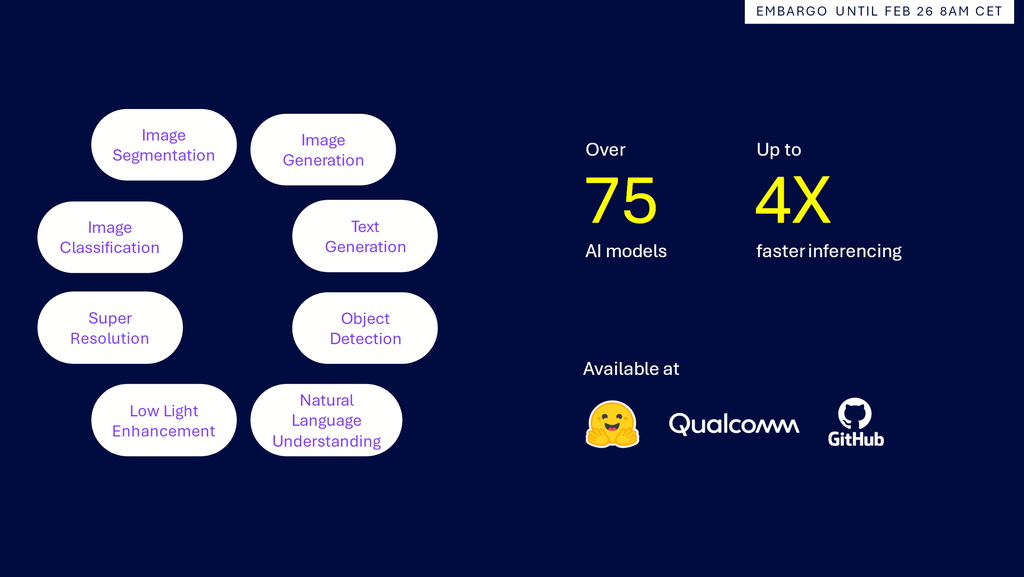

Já no lançamento, mais de 75 modelos estarão disponíveis, incluindo códigos em TensorFlow, PyTorch e ONNX preparados para geração de imagens, geração de texto, segmentação de imagens, super resolução, aprimoramentos de capturas em baixa luminosidade e compreensão de linguagem natural. Conforme explica a companhia, com as otimizações para chips Snapdragon, seria possível obter desempenho de inferência até quatro vezes maior em comparação aos formatos não otimizados.

Outro ponto interessante é que esses modelos não estariam restritos ao Qualcomm AI Hub — também será possível ter acesso a eles pelo GitHub, ou ainda por meio de repositórios no Hugging Face. Ao que parece, o maior diferencial da biblioteca proprietária da Qualcomm é agilizar a integração da IA nos apps ao mostrar as melhores opções disponíveis de acordo com os dispositivos escolhidos pelo desenvolvedor.

Qualcomm mostra modelos multimodais no celular

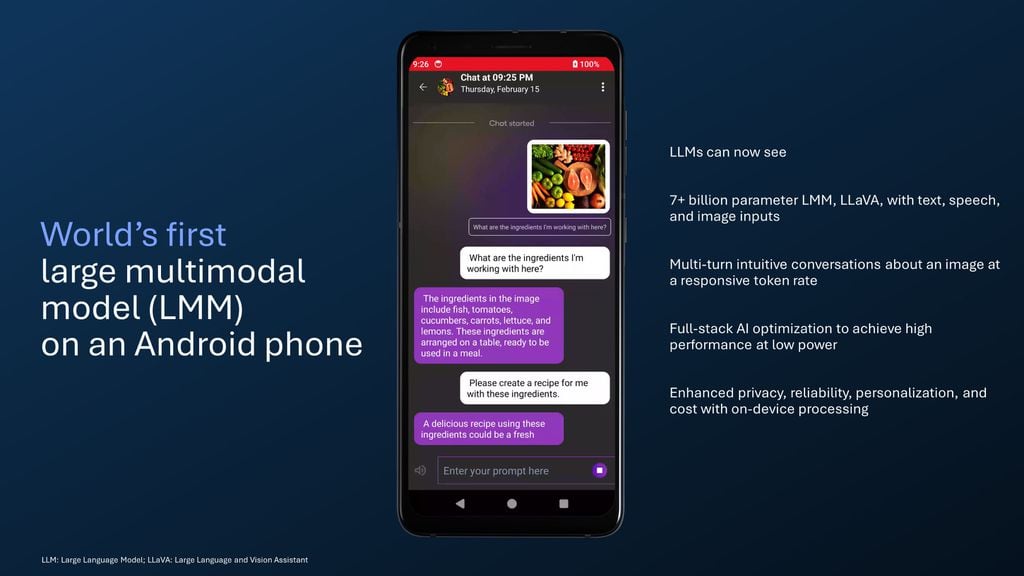

Aproveitando a oportunidade, a Qualcomm realizou duas demonstrações inéditas de IA generativa em smartphones, que complementam o exemplo com a Llama da Meta feito durante o Snapdragon Summit em outubro passado. Esta seria a primeira vez que um Grande Modelo Multimodal (LMM) — os modelos que podem receber e interpretar dados de texto, áudio e imagem simultaneamente — seria demonstrado em um celular.

A primeira delas trabalha com o LLaVA (Large Language and Vision Assistant), modelo de código aberto com cerca de 7 bilhões de parâmetros desenvolvido pelo time de pesquisa da Microsoft em parceria com as Universidades de Columbia e de Wisconsin-Madison. Como o nome sugere, a solução tem a intenção de ser um assistente virtual que trabalha com comandos e respostas baseados em textos, sons e imagens.

Curiosamente, a Qualcomm não divulgou a taxa de tokens (o número de termos gerados amplamente usado para medir a velocidade de execução da IA), nem qual processador foi usado, mas a marca garante que uma experiência responsiva foi obtida. A característica mais importante é a execução do modelo no dispositivo, localmente, sem ser preciso acessar a nuvem, o que garantiria maior segurança e privacidade para os usuários.

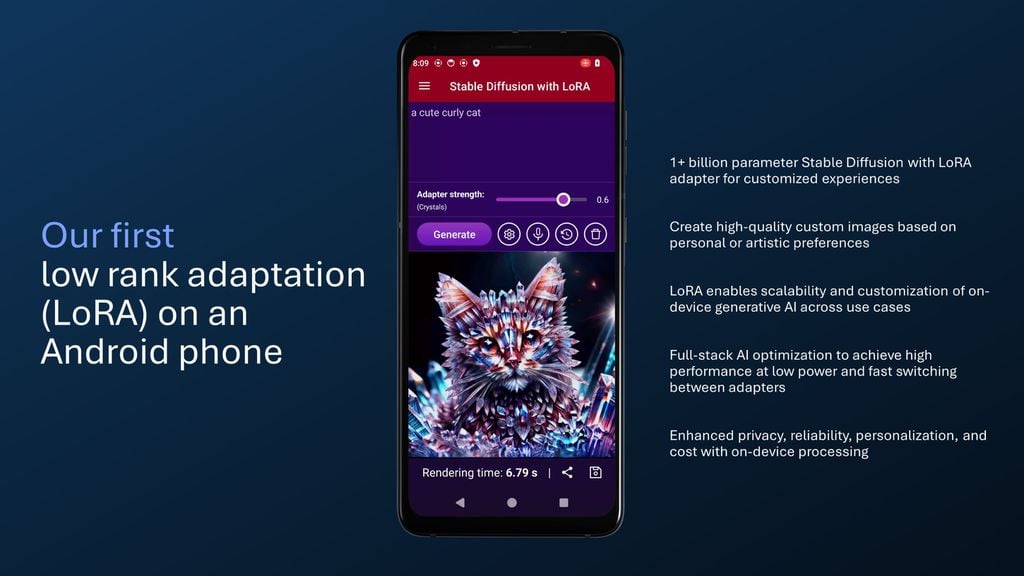

O segundo teste mostra o Stable Diffusion, modelo de geração de imagens a partir de texto, rodando com Low Rank Adaptation, ou LoRA, ferramenta que permite ao usuário fazer ajustes nos resultados a cada treinamento da IA. Essa funcionalidade também é inédita nos telefones, e seria um passo importante para turbinar o uso de IA em smartphones, oferecendo mais eficiência e a possibilidade de personalizar os modelos.

Leia a matéria no Canaltech.

Trending no Canaltech:

- Xiaomi lança câmera de segurança CW500 com preço baixo e proteção contra chuva

- Os 10 filmes mais vistos da semana (24/02/2024)

- Artigo científico com imagens esdrúxulas de IA é retirado do ar

- 10 comandos legais para usar no Gemini

- Presença de chumbo em copo Stanley rende processos à empresa

- Xiaomi 14 Pro ganha comunicação via satélite e fica ainda mais caro